admin / 11.07.2018

Нейронные сети программирование

Содержание

- Нейронные сети.

- Пример программы нейронной сети с исходным кодом на с++.

- Программирование искусственных нейронных сетей — я пишу на С++ в объектно-ориентированной парадигме

- Нейронные сети

- Искусственная нейронная сеть

- Объяснение тонкой настройки в ИТВ

- На каком языке программирования писать нейронные сети?

Нейронные сети.

Пример программы нейронной сети с исходным кодом на с++.

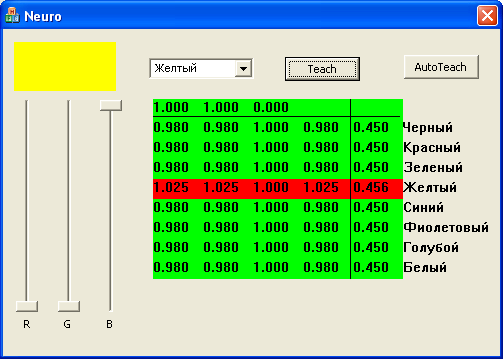

Про нейронные сети хорошо и подробно написано здесь. Попытаемся разобраться как программировать нейронные сети, и как это работает. Одна из задач решаемых нейронными сетями, задача классификации. Программа демонстрирует работу нейронной сети классифицирующей цвет.

В компьютере принята трехкомпонентная модель представления цвета RGB, на каждый из компонентов отводится один байт. полный цвет представлен 24 битами, что дает 16 миллионов оттенков. Человек же может отнести любой из этих оттенков к одному из имеющих название цветов. Итак задача:

Дано InColor — цвет RGB (24 бит)

классифицировать цвет, т.е. отнести его к одному из цветов заданных множеством М={ Черный, Красный, Зеленый, Желтый, Синий, Фиолетовый, Голубой, Белый }.

OutColor — цвет из множества М

Решение номер 1. (цифровое)

Создаем массив размером 16777216 элементов

|

int8 ColorTab [ 16777216 ]; |

инициализируем его правильными значениями.

Ответ получаем очень быстро

|

OutColor = ColorTab [ InColor ]; |

Решение номер 2. (аналоговое)

напишем функцию, типа

|

int8 GetColor(DWORD Color) |

Это будет работать если задачу можно описать простыми уравнениями, а вот если функция настолько сложна что описанию. не поддается, здесь то на помощь приходят нейронные сети.

Решение номер 3. (нейронная сеть)

Простейшая нейронная сеть. Однослойный перцептрон.

Все нейронное заключено в класс CNeuroNet

|

#define INCOUNT 3 struct Neuron int m_NeuroCount; }; |

Каждый нейрон имеет 3 входа, куда подаются интенсивности компонент цвета. (R,G,B) в диапазоне (0 — 1). Всего нейронов 8, по количеству цветов в выходном множестве. В результате работы сети на выходе каждого нейрона формируется сигнал в диапазоне (0 — 1), который означает вероятность того что на входе этот цвет. Выбираем максимальный и получаем ответ.

Нейроны имеют сигмоидную функцию активации ActiveSigm(). Функция ActiveSigmPro(), производная от сигмоидной функции активации используется для обучения нейронной сетиметодом обратного распространения.

В первой строчке выведены интенсивности цветов. ниже таблица весовых коэффициентов (4 шт. ). В последнем столбце значение на выходе нейронов. Меняем цвет, выбираем из списка правильный ответ, кнопкой Teach вызываем функцию обучения. AutoTeach вызывает процедуру автоматического обучения, 1000 раз, случайный цвет определяется по формуле из решения номер 2, и вызывается функция обучения.

скачать исходный код и программу нейронной сети

Программирование искусственных нейронных сетей — я пишу на С++ в объектно-ориентированной парадигме

Для простых нейроархитектур (структур), методов и задач можно использовать любой язык (даже Бэйсик), но для сложных проектов наиболее пригодными оказываются языки объектно-ориентированного программирования (такие, как С++). Я применяю именно С++, при необходимости (в наиболее времязатратных местах программы) переписывая отдельные функции (требующие ускорения вычислений) на инлайн-ассемблере.

Покажем пользу объектно-ориентированного подхода к программированию нейросеток. У нейросети может быть множество вариантов нейронов и/или слоёв (см. заметку про современные возможности собрать свёрточную нейросеть из большого числа разнотипных слоёв и нейронов). Некоторую общую функциональность нейронов или слоёв можно вынести в абстрактный класс-предок, порождая (наследуя) от него классы для тех или иных видов нейронов/слоёв (эти классы-потомки будут описывать-реализовывать уже уникальные для конкретного вида нейрона или слоя особенности и поведение). Таким образом обеспечиваются ликвидация многократного дублирования общих (одинаковых) вещей в тексте программы и возможность написать более гибкий и независимый от конкретных типов нейронов/слоёв управляющий код программы при использовании принципов полиморфизма.

В качестве примера рассмотрим номенклатуру классов для описания слоёв нейросети в одной из разработанных мной программ. Имеется 3 основных иерархии − одна для классов-описателей структуры слоя (цепочка наследования из трёх классов), вторая − для нелинейных функций нейронов (базовый класс и десять наследников от него), третья − для самих слоёв (цепочка из 5 базовых-промежуточных классов и 12 реальных классов, отпочковавшихся от этой цепочки на разных её уровнях).

Т.е.

Нейронные сети

в тексте программы для описания поведения слоёв сети использован (реализован) 31 класс, но при этом всего 12 из них реализуют реальные слои, а остальные классы:

- либо абстрактные, задающие общее поведение, позволяющие в дальнейшем более просто создавать новых потомков (новые типы слоёв) и повышающие степень инвариантности управляющей логики (реализующей функционирование нейронной сети) к составляющим сеть разнообразным слоям;

- либо, наоборот, являются подчинёнными и входят в состав слоя в качестве его «компонент» (экземпляр объекта-описателя структуры и характеристик слоя, и экземпляр объекта, реализующего нелинейную функцию нейронов).

Функционирование созданной нейронной сети запрограммировано через обращения к методам и свойствам абстрактных классов, независимо от того, какой конкретно класс-потомок реализует тот или иной слой нейросети.

Т.е. управляющая логика здесь отделена от конкретного содержания и привязана только к общим, инвариантным основам. О конкретных же классах необходимо знать только коду «конструктора» нейросети − работающего только в момент создания новой сети исходя из заданных в интерфейсе настроек или при загрузке ранее сохранённой сети из файла. Добавление новых типов слоёв нейронов в программу не приведёт к переделке алгоритмов (логики) работы и обучения сети − а потребует только небольшого дополнения кода механизмов создания (или чтения из файла) нейросети.

Абстракций (классов) для отдельных нейронов нет — только для слоёв. Если нужно поставить на некотором (а именно — на выходном) слое единственный нейрон — то просто экземпляру класса нужного нейронного слоя при создании передаётся счётчик числа нейронов, равный единице.

Таким образом, объектно-ориентированные проектирование и программирование обеспечивают бОльшую гибкость для реализации принципа «разделяй и властвуй» по сравнению со структурным программированием, через:

- вынос общих фрагментов кода в классы-предки (принцип наследования),

- обеспечение необходимого сокрытия информации (принцип инкапсуляции),

- построение-получение универсальной, независимой от конкретных реализаций классов, внешней управляющей логики (принцип полиморфизма).

- достижение кросс-платформенности через вынос аппаратно- или платформозависимых частей в классы-потомки (число которых может меняться под каждую конкретную программно-аппаратную реализацию, в то время, как число базовых классов-предков и вся логика высокого уровня будут одинаковы и неизменны).

Для современных задач разработки гибких и мощных инструментов нейромоделирования всё это оказывается очень полезным.

Также см. пост про проекты специальных языков описания ИНС.

далее: точность решения задач нейронными сетями.

NeuroPro

нейронные сети,

методы анализа данных:

от исследований до разработок и внедрений

Главная

Услуги

Нейронные сети

• базовые идеи

• возможности

• преимущества

• области применения

• как использовать

• точность решения

• НС и ИИ

Программы

Статьи

Блог

Об авторе / контакты

Тонкая настройка Вселенной — это уникальное сочетание многочисленных свойств Вселенной такое, что только оно и способно обеспечить существование наблюдаемой Вселенной. Даже минимальные отклонения состава или значений этих свойств несовместимы с фактом существования Вселенной.

Обычно понятие тонкой настройки Вселенной рассматривается в слабой формулировке: принимаются во внимание значения всего нескольких мировых констант, и делается вывод только о невозможности существования человечества при их отклонениях. Такой ограниченный подход стимулирует религиозно окрашенные попытки объяснения этого явления, например, антропный принцип, декларирующий богоданную целесообразность Вселенной, заключенную в существовании человека.

Тонкая настройка Вселенной — это самая впечатляющая из аперцепций современной космологии: никакая другая не сравнится с ней по силе и убедительности свидетельства о Большом тупике, о том, что Вселенная устроена категорически не так, как её представляет современная наука, и в рамках этого представления исследует. Не несколько констант, а вообще непредставимо огромный корпус разнообразных фактов, имей любой из них даже небольшое отличие от наблюдаемого, сделал бы невозможным существование жизни и Вселенной. Значения свойств элементарных частиц (массы, заряды, периоды полураспада…), свойства фундаментальных взаимодействий, свойства веществ (да хотя бы воды), — всё это и многое-многое другое тщательно выбрано именно таким, чтобы Вселенная существовала. Любой из миллионов этих фактов, будь он другим, привёл бы её к несуществованию. Или, как минимум (в слабой формулировке) — к невозможности жизни в ней.

Искусственная нейронная сеть

Осознание этого полностью разрушает привычную "научную картину мира" эпохи Большого тупика. Но, как уже сказано, здесь имеет место аперцепция: люди отказываются осознавать это.

Объяснение тонкой настройки в ИТВ

ИТВ устанавливает, что Вселенная состоит только из информации. Наблюдатель наблюдает наблюдаемое, получая информацию — и это всё, что составляет Вселенную. Информация, будучи всего лишь описанием чего-либо, могла бы быть любой возможной, если бы она получалась сама по себе. Однако информация сама по себе ничем не является и ничего описывать не может, для этого всегда нужны некоторые условия, и они ограничивают содержание информации.

Таким образом, Вселенная — это совокупность обусловленных выборов конкретной наблюдаемой информации из широкой гаммы в принципе возможной. Существование Вселенной является финальным критерием всех этих выборов: они таковы постольку, поскольку Вселенная существует, будь они другими — Вселенная не существовала бы.

Это и есть тонкая настройка Вселенной: значения мировых констант и вообще все свойства Вселенной определились фактом существования Вселенной, никто их специально не подбирал, ни из какой единой константы они не выводятся, никакой возможности установить их иной состав и иные значения не существует.

|

версия 1 от 17.04.2014 07:12 msk (актуальная) |

Разбираем нейронную сеть. C#

Пару слов, необходимо уделить устройству этой самой «великой» и «ужасной» нейронной сети. Долгое количество времени люди ходили взад и вперед и размышляли над вопросом: (в чем смысл жизни?)

Как можно распознавать образы?

Ответов было огромное множество. Тут и различные эвристики, и сравнения по шаблонам и многое-многое. Одним из ответов была нейронная сеть. [К слову сказать нейронная сеть может не только распознавать образы]

Итак. Структура нейронной сети. Представьте себе такую картину: паук сплел сеть и сеть словила муху. То место на которое попала муха и есть нейрон, который был «максимально» близок к цели. Нейронная сеть состоит из нейронов, которые «описывают»

шансы того или иного события. Описание «вероятности» события (каждого нейрона) может храниться (к примеру) в отдельном файле.

Теперь переходим к главной теме разговора этого вечера.

Как устроена нейронная сеть.

Как происходит ее обучение и распознание.

Пример структуры нейронной сети отчеливо виден на этой картинке:

На вход поступает множество входных сигналов X. Которые умножаются на множество весов W (Xi * Wi). В нейроне производится подсчет суммы произведений и на выход отправляется некоторое число.

После подсчета значений у всех нейронов, производится поиск наибольшего значения. Это наибольшее значение и считается корректным ответом на вопрос. Программой выдается образ, который описывается найденным нейроном.

В режиме обучения пользователь имеет возможность подправить результат (основываясь на своем опыте) и тогда программа произведет пересчет весов нейронов.

Формула перерасчета примерно следующая: W[i] = W[i] + Speed*Delta*X[i] — здесь

W[i] — вес i-го элемента,

Speed — скорость обучения,

Delta — знак (-1 или 1),

X[i] — значение i-го входящего сигнала (во многих случаях 0 или 1)

Зачем используется delta?

Разберем такой случай.

На вход программе подается картинка с цифрой 6.

На каком языке программирования писать нейронные сети?

Нейронная сеть распознала цифру 8. Пользователь правит цифру на 6. Что происходит далее в программе?

Программа пересчитывает данные для двух нейронов, описывающих число 6 и число 8, причем для нейрона, описывающего число 6 delta будет равна 1, а для 8 = -1

Как задается параметр скорости?

Данный параметр, чем меньше тем, дольше и точнее(качетственнее) будет происходить обучение сети, и чем больше, тем быстрее и «поверхностней» будет происходить обучение сети.

Параметр Speed может задаваться как вручную, пользователем, так и в ходе выполнения программы( к примеру const)

Как видно, весы символов также должны быть определены. А чем они определяются изначально? на самом деле тут также все просто. Определяются они совершенно случайно, это позволяет избежать «предвзятости» нейронной сети. Обычно, интервал случайных значений небольшой -0.4…0.4 или -0.3..0.2 и т.п.

Теперь переходим к самой интересной части. Как это закодировать!

Создадим два класса — класс Нейрон и класс Сеть (Neuron и Net соответственно)

Опишем основные задачи класса Neuron:

— Реакция на входной сигнал

— Суммирование

— Корректировка

(как дополнительно можно добавить чтение из файла, создание начальных значений, сохранение. Оставим это на «совести» читающих)

Переменные внутри класса Neuron:symbol

— Идентификатор «опознания» — LastY

— Описываемый образ — symbolsymbol

— Весы List

FILED UNDER : IT